En la década de 1960 Woodrow W. Bledsoe creó un programa secreto que identificaba manualmente puntos en el rostro de una persona y comparaba las distancias entre estas coordenadas con otras imágenes.

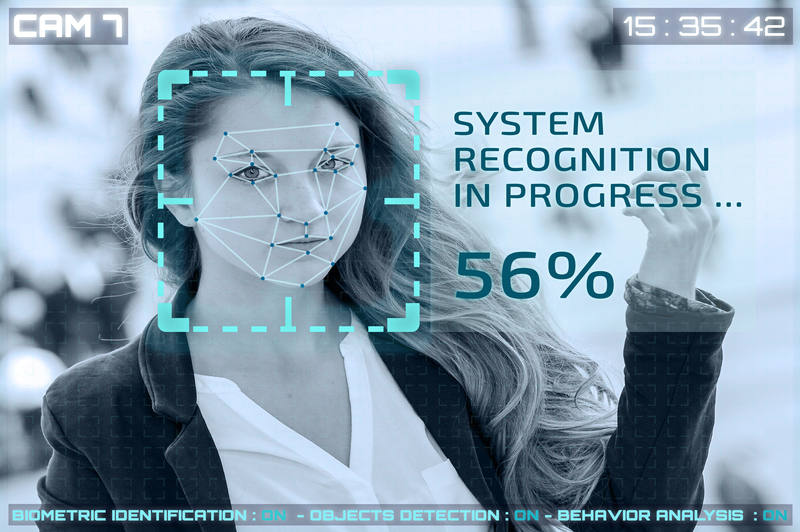

La tecnología de reconocimiento facial ha recorrido un largo camino desde entonces. El entorno ha evolucionado rápidamente y el software puede ahora procesar automáticamente cantidades asombrosas de datos faciales en tiempo real, mejorando drásticamente los resultados (y la fiabilidad) de la comparación en una variedad de casos de uso.

A pesar de todos los avances que hemos visto, muchas organizaciones todavía dependen del mismo algoritmo utilizado por la base de datos de Bledsoe, conocido como «vecinos más cercanos» o k-NN. Dado que cada cara tiene múltiples coordenadas, una comparación de estas distancias sobre millones de imágenes faciales requiere un importante procesamiento de datos. El algoritmo k-NN simplifica este proceso y facilita la comparación de estos puntos reduciendo considerablemente el conjunto de datos. Pero eso es sólo una parte de la ecuación. El reconocimiento facial también implica encontrar la ubicación de un rasgo en una cara antes de evaluarlo. Esto requiere un algoritmo diferente como el HOG (llegaremos a él más tarde).

El problema

Los algoritmos utilizados para el reconocimiento facial hoy en día se basan en gran medida en modelos de machine learning (ML), que requieren una formación importante. Lamentablemente, el proceso de aprendizaje puede dar lugar a distorsiones en estas tecnologías. Si el adiestramiento no contiene una muestra representativa de la población, el ML no podrá identificar correctamente a la población que se ha perdido.

Si bien esto puede no ser un problema significativo cuando se comparan los rostros para las plataformas de redes sociales, puede ser mucho más perjudicial cuando el software de reconocimiento facial de Amazon, Google, Clearview AI y otros es utilizado por organismos gubernamentales y las fuerzas del orden.

Estudios anteriores sobre este tema descubrieron que el software de reconocimiento facial sufre de sesgos raciales, pero en general, la investigación sobre ello ha sido escasa. Las consecuencias de tales sesgos pueden ser nefastas tanto para las personas como para las empresas. Para complicar aún más las cosas, está el hecho de que incluso pequeños cambios en el rostro, el cabello o el maquillaje pueden afectar la capacidad de una modelo para adaptarse con precisión a los rostros. Si no se tiene en cuenta esto puede crear dificultades claras cuando se trata de aprovechar la tecnología de reconocimiento facial para identificar a las mujeres, que por lo general tienden a utilizar más que los hombres los productos de belleza y de autocuidado.

Intentando comprender el sexismo en el software de reconocimiento facial

¿Cómo de malas son las identificaciones erróneas basadas en el género? Nuestro equipo en WatchGuard realizó algunas investigaciones adicionales de reconocimiento facial, mirando únicamente los sesgos de género para averiguarlo. Los resultados fueron reveladores. Las soluciones que evaluadas identificaron erróneamente a las mujeres con un 18 % más de frecuencia que a los hombres.

Puedes imaginar las terribles consecuencias que este tipo de sesgo podría generar. Por ejemplo, un teléfono inteligente que se basa en el reconocimiento facial podría bloquear el acceso; un oficial de policía que utiliza un software de reconocimiento facial podría identificar erróneamente a un transeúnte inocente como un delincuente, o un organismo gubernamental podría llamar a la persona equivocada para interrogarla basándose en una falsa coincidencia. La lista continúa. La realidad es que el culpable de estos problemas es el sesgo dentro de la formación de modelos que crea sesgos en los resultados.

Cómo descubrimos estos resultados

Cómo descubrimos estos resultados

Nuestro equipo realizó dos pruebas separadas, la primera usando Amazon Rekognition y la segunda usando Dlib. Lamentablemente, con Amazon Rekognition no pudimos analizar cómo funciona su algoritmo y modelado ML debido a problemas de transparencia (aunque asumimos que es similar a Dlib). Dlib es una historia diferente, y utiliza recursos locales para identificar las caras que se le proporcionan. Viene previamente entrenado para identificar la ubicación de un rostro y con el buscador de ubicación de caras HOG, un algoritmo más lento basado en la CPU, y CNN, un algoritmo más rápido que utiliza procesadores especializados que se encuentran en las tarjetas gráficas.

Ambos servicios proporcionan resultados que coinciden con información adicional. Además de la similitud encontrada, se da una puntuación de semejanza que muestra lo cerca que debe estar una cara de la cara conocida. Si la cara archivada no existe, una puntuación de similitud establecida en baja puede hacer coincidir incorrectamente una cara. Sin embargo, una cara puede tener una puntuación de similitud baja y aun así coincidir cuando la imagen no muestra la cara con claridad.

Para el conjunto de datos, usamos una base de datos de caras llamada «Labeled Faces in the Wild «, y solo investigamos las caras que coincidían con otra cara en la base de datos. Esto nos permitió probar las caras coincidentes y los resultados de similitud al mismo tiempo.

Amazon Rekognition identificó correctamente todas las imágenes que le suministramos. Sin embargo, cuando miramos más de cerca los datos proporcionados, nuestro equipo vio una distribución más amplia de las similitudes en los rostros femeninos que en los masculinos. Vimos más caras femeninas con mayores similitudes que los hombres y más rostros femeninos con menos similitudes que los hombres (esto en realidad coincide con un reciente estudio realizado alrededor de la misma época).

¿Qué significa esto? Esencialmente significa que una cara femenina no encontrada en la base de datos es más probable que proporcione una falsa coincidencia. Además, debido a la menor similitud de los rostros femeninos, nuestro equipo confiaba en que veríamos más errores en la identificación de los rostros femeninos que de los masculinos si se les daban suficientes imágenes con rostros.

Amazon Rekognition dio resultados precisos, pero faltó consistencia y precisión entre los rostros masculinos y femeninos. Los rostros masculinos eran de media un 99,06% similares, pero los rostros femeninos eran de media un 98,43% similares. Esto puede no parecer una gran variación, pero la brecha se amplió cuando miramos los valores atípicos: una desviación estándar de 1,64 para los hombres frente a 2,83 para las mujeres. Más rostros femeninos caen más lejos del promedio que los masculinos, lo que significa que la falsa coincidencia femenina es mucho más probable que la diferencia del 0,6% basada en nuestros datos.

Dlib no funcionó tan bien. De media, Dlib identificó erróneamente las caras de las mujeres más que las de los hombres, lo que llevó a una tasa promedio de un 5% más de mujeres identificadas erróneamente. Cuando se comparan las caras usando el HOG más lento, las diferencias crecieron hasta el 18%. Como dato de interés, nuestro equipo encontró que, de media, las caras femeninas tienen mayores puntuaciones de similitud que las masculinas cuando se usa Dlib, pero como en el caso de Amazon Rekognition, también tienen un mayor espectro de puntuaciones de similitud que conducen a los bajos resultados que encontramos en la precisión.

Abordar el sesgo del reconocimiento facial

Desafortunadamente, los proveedores de software de reconocimiento facial intentan ser transparentes en cuanto a la eficacia de sus soluciones. Por ejemplo, nuestro equipo no encontró ningún lugar en la documentación de Amazon en el que los usuarios pudieran revisar los resultados del procesamiento antes de que el software realizara una coincidencia positiva o negativa.

Lamentablemente, esta suposición de exactitud (y la falta de contexto de los proveedores) probablemente dará lugar a más y más casos de detenciones injustificadas, como este. Es muy poco probable que los modelos de reconocimiento facial alcancen una precisión del 100% en un futuro próximo, pero los representantes de la industria deben centrarse en mejorar su eficacia de todos modos. Sabiendo que estos programas contienen prejuicios hoy en día, las fuerzas del orden y otras organizaciones deberían utilizarlos como una de las muchas herramientas, no como un recurso definitivo.

Pero hay esperanza. Si la industria puede reconocer y abordar honestamente los sesgos del software de reconocimiento facial, podemos trabajar juntos para mejorar la formación y los resultados de los modelos, lo que puede ayudar a reducir las identificaciones erróneas no solo basadas en el género, sino también en la raza y otras variables.

Trevor Collins

Security analyst, WatchGuard Technologies